1990年代の後半から20年間、ずっと「これは問題だ」と言い続けていることがありました。

それは、サウンドライブラリーの殆どが44.1Khzでレコーデイングされているということです。

当時は音楽クリエイター仲間でも理解してくれる人は少なかったです。

最近はやっと理解してくれる人が出てきました。

いや、少なくとも20年前に気づいてれととは思うのですが…。

そう言えばこれまでブログに書いてなかったので、自分の制作方法を整理するためにもマトメてみようと思います。

昔から主流は48K

デジタルレコーディングが登場して依頼、あらゆる分野において主流は48Kです。

スタジオは48K

1980年代半ばに世界中のレコーディングスタジオで定番となったSONYのPCM-3348という48KHzのデジタルレコーダーも48Khz。

PCM-3348を導入する様な大型スタジオではなく、小型の小規模プロダクションスタジオなどではDATと呼ばれるデジタル・オーディオ・テープがスタンダードになりましたが、これも48K。

44.1Kのモードも選べますが、特殊な事例を除いてわざわざ44.1Kモードを選択する理由はありませんでした。

1990年代に入ると、ADATやTASCAMなどが安価(といっても30万円〜70万円ほどしていましたが)な8chのデジタル方式のマルチトラックレコーダーをリリースし、主に小型のプロダクションスタジオで一斉を風靡しました。

僕も大学生の時に、総額300万円近い投資をしてADATとデジタル・ミキサーを揃えて制作の受注を取れるようになっていました。

放送関係は48K

放送関係も48Kです。

1回り上の先輩方はアナログオープンテープを回していた話を聞きます。

僕は直接放送関係に関わる仕事は行っていませんが、1990年代後半頃からは、放送関係が1番デジタル化への対応が早かったように認識しています。

MOフォーマットなどのノンリニア編集黎明期の最新システムも積極的に導入されていました。

局内の運用フォーマットは各所で違うでしょうが、音楽を収める立場の僕はDATの48Kが多かったです。

映像も48K

放送と同様にデジタルの映像プラットフォームも昔から48Kが基本です。

CMや番組の音楽を納品するときも全て48Kでした。

現在の主流なプラットフォームも48K

現在、多くの人が音に接するプラットフォームとしては、放送やフィジカルメディアからYouTubeなどの動画配信サービスや、音楽ストリーミング配信に変わったと思います。

これらも基本は48Kと考えて良いです。

これらのプラットフォームではリニアPCMではなくエンコードされたデータが使用されています。

通信やサーバーの負荷を減らすためにデータ容量を削減する処置が取られ不可逆圧縮などと呼ばれています。これらのデータをアップロードする際には、サンプリングレートは48Kにこだわる必要はなく、一般的なサンプリングレートであれば対応しています。

ではなぜYouTubeなども48Kが基本と考えるのでしょうか?

答えはその前の編集段階が48Kだからです。

Premiere Pro や Final Cut などに代表されるように映像編集ツールが音声を48Kで扱っているます。

つまり、44.1Kで映像編集用に音楽を搬入しても、映像編集ツールでのインポート時に48Kにデジタル演算でのSRコンバートを掛けられてしまうのです。

44.1Kライブラリーの問題点

このSRコンバートが問題なのですが、次はこれについては解説していきます。

44.1Kの音自体は悪くない

まず前提として、僕が今回取り上げている内容は「44.1Kは音が悪い」という話ではありません。

もちろんスペック的に48Kが有利なのは間違いないです。

が、適切に制作されたソースであれば44.1Kでもそれほど大きな問題にはなりません。

現にCDは44.1Kで素晴らしい音質の作品が沢山存在します。

問題はサンプリングレートコンバートの方法

問題はデジタル演算によるサンプリングレートコンバートです。

ここではサウンドの質感には大きな害悪を及ぼします。

ライブラリーのSRは気にせずに48Kで制作しています。

楽曲制作時にCubaseやLogic、Studio One などの曲作りのDAWのSRを48Kに設定する。

こういう音楽クリエイターは多いと思います。

44.1Kライブラリーのインストゥルメントトラックを多用する場合あ、僕は44.1Khzで作業します。

機能面だけで言えば48Kに設定すれば、48Kで再生します。

が、サウンドクォリティ面ではベストではありません。

問題はないと考えて48Kで使用している音楽クリエイターが多いことも知っています。

強く強制するつもりはありませんが、ここで3つの例を上げておきます。

事例1:サンプリングレートコンバートのCPUパワー

リアルタイムとスローレンダリングの差

ProToolsで44.1KhzのWAVファイルを48Kや96Kで取り込む際の例で話をします。

この作業の際のSRコンバージョンのアルゴリズムはFastからBest(Slow)まで複数段階があります。

Fastは音質よりも演算処理の速度優先。

Bestが時間は掛かるが可能な限り劣化を抑えてSRコンバージョンを行うアルゴリズムです。

ポイントはBestの場合において実演時間よりも多くの時間が必要なことです。

これはマスタリングをする立場でもあるので言えることなのかもしれませんが、どんなに最新の演算アルゴリズムを用いて時間を掛けて変換をしても聴き比べるとガッカリします。

奥行き感、明瞭度、上下のレンジ感など明らかに別物になります。

これは学生でもアシスタントでも、スタジオで聴けば直ぐに分かる明確な差です。

それだけ高精細に演算処理した音質でもパーフェクトではありません。

それに対して、DAWを48Kに設定して44.1Kのライブラリーを使うというのはどういうことか?

これらは全てリアルタイムで処理しています。

その上で様々なミックス処理もリアルタイムで行っています。

BestでのSRコンバージョンより優秀なのでしょうか?

かもしれませんが、僕が実験をした限りではそうではありませんでした。

ピッチ補正ツールは万能ですか?

実際44.1Khzのサウンドライブラリ―を正しい音程で48Kで再生させるためには、リアルタイムでピッチ変更(≒速度変更)の処理が必要です。

一般的なピッチ修正ツールで全く音質を変化させずに修正してくれるツールは今のところないです。

昔に比べば相当良くなっていまし、スタジオワークでは必需品と言えるくらい今ではまず使用しないことはないツールです。が、それでも音質に良いものではないので、できるだけ最低限、最小限の使用に留めるべく、多くのクリエイターやエンジニアは心がけていると思います。

生楽器系のライブラリー再生も同じ僕は同様に考えています。

事例2:88.2Kが使われるケース

2000年代に入り96Khzや192KhzのハイレゾリューションのオーディオI/OやAD/DAコンバーターが登場してくると、88.2Khzは176.4Khzという44.1Kの倍数も選択できるようになりました。

DAWの普及や制作費の低下に伴って、マスタリングスタジオを使用せず、DAWでバウンスしたミックスファイルをそのままCDのプレスマスターに利用すると音楽クリエイターやエンジニアが増えました。

当初はこれまでのセオリー通り48Kなどでレコーディングやミックスを行い、最終的に44.1KhzにダウンSRコーバ―トを行っていました。

が多くの音楽クリエイターやエンジニアはそれによるサウンドの変化に悩まされるようになります。

そして次第に、

どうせCDでしかリリースしない作品なのだから44.1K(88.2K)で録音とミックスを行えばOK。

という考え方がそれなりの広く浸透していきました。

この方法でレコーディングしている同業は結構いました。

事例3:最近あったプチ・エピソード

これはつい先日に実際にあった話です。

とあるクラシック音楽家団体から、

〇〇さんから頂いたマスターCDが皆さん納得できていなくて

と相談を受けました。

お預かりしたデータを開いたらレコーディングとミックスは48Khzのファイルでした。

そしてマスターのデータをみると44.1KにSRコンバートを用いてバウンスした44.1Khzのマスターファイルだということが分かりました。

これは音を聴けばミックスの音と違うので直ぐに分かります。

位相が微妙にくずれ何とも言えない空気感を感じさせていました。

クラシックということでホールの残響などもとても繊細ですので、より繊細な処理の不具合が明確に露出してしまうというのもあります。

本人たちは「何かが違う」とエンジニアに2~3度修正依頼を出したが、エンジニアも原因が分からないのでミックスを何度もやり直したようです。

全く解決せず最終的にエンジニアが「CDとはこういう物だ」となってクライアントと距離ができてしまったとの事。

そして人伝にフルハウスを紹介されて僕の所に辿り着いたという経緯だったようです。

僕は演算処理によるSRコンバートは行いません。

いつも通りのマスタリング手法で44.1KのCDマスターを作成しました。

そしたらサクッと解決。

皆さん、その音の輝きや空気感の違いに感動され一発OKでした。

そのCDは数十曲が収録される2枚組のため、時間と予算の都合により全曲の再ミックスとマスタリング行うことはできませんでした。

それだけに演算処理によるSRコンバートした物と、そでない物との音質差が丸わかりになっていまして面白いCDになっています。

演算処理によるSRコンバージョンはベストでない

これらの事例を踏まえれば「SRコンバージョンに問題がある」という話は僕が神経質だからでも拘りすぎるからでもなく、極一般的な事例だというのを分かって頂けると思います。

が、事例3のように「分からない」「分かるけど気にしない」という人も多いので全てにおいて否定しているわけではありません。

僕の場合はとくに生演奏録音と組み合わせてシンセサイザートラックを使うことが多いです。

そのため常に生演奏に負けない本来の質感の音をどうトラッキングするか考えているからこそ、というのはあると思います。

サンプルライブラリーはなぜ44.1Kを採用したのか?

なぜ多くのサウンドライブラリ―メーカーが44.1Khzを採用してしまったのか?というのはいくつかの時代的な理由が重なっていて、僕は次の3つを上げています。

- CDが44.1Khzを採用したから

- シーケンスソフトのDAW化とCD-Rの登場

- データ容量の削減やPC負荷の低減

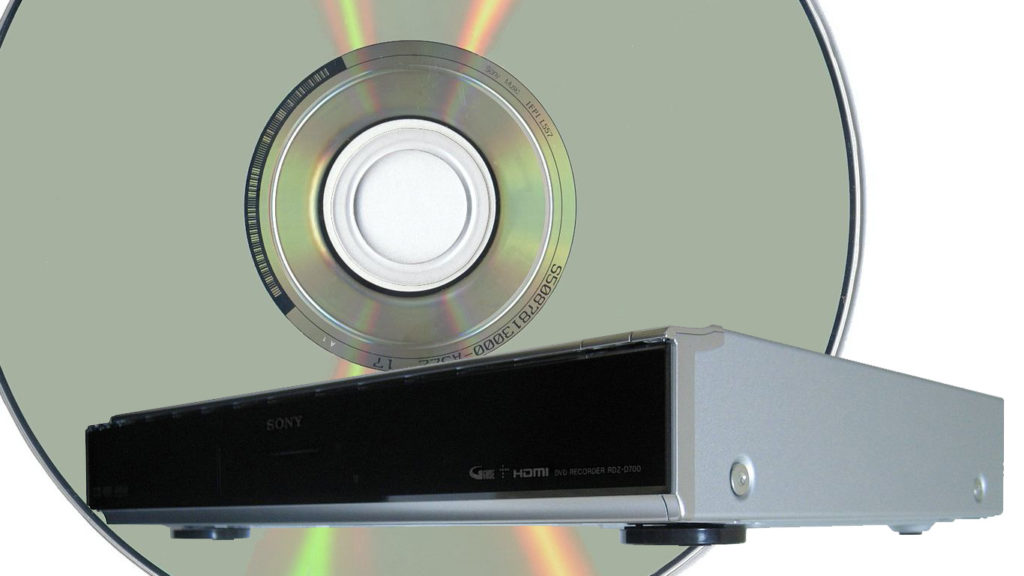

CDが44.1Khzを採用したから

まずは音楽CDが44.1Kを採用していたからというのが全ての始まりです。

エンドユーザー視点では主流はCDというフィジカルメディアの自体が長かったです。

ただ、実際の制作現場では44.1Khz(≒88.2Khz)が使われたのは、かなり特殊な環境と短い期間だけというのは今後のためにも抑えておく必要があります。

少しそのあたりを解説します。

CDのマスターは分けて考える

僕の感覚からすると44.1Kで制作をするという事自体が、昔から常に違和感があり常に主役は48Kでした。

専門的なスタジオや制作の現場では48K(≒96K、192K)での制作が主流というのは冒頭から書いてきました。

レコーディングや制作の基本は「音が良くなるように可能な限り現実的な範囲でハイレートで録音する」という基本原則があります。

(特殊な一部のジャンルは除いて)

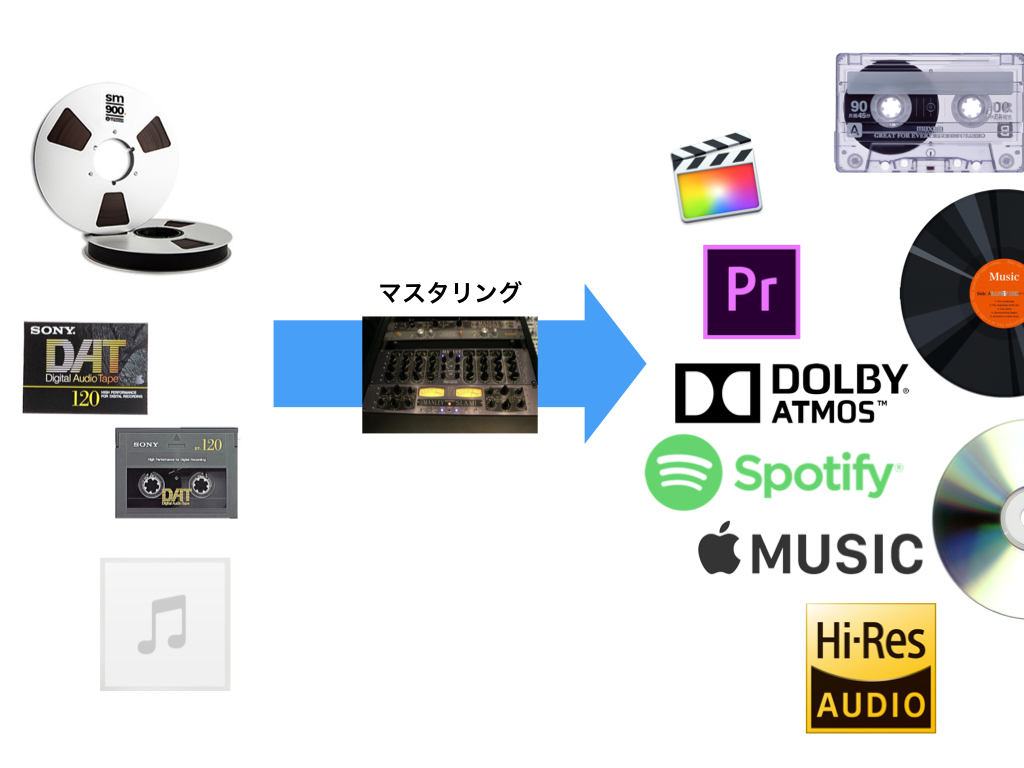

マスタリングで各フォーマットに落とし込む

なぜかというと、

最終的なフォーマットはメディア毎にバラバラ

というがどんな時代でもついてまわるからです。

昔であれば、CDだけではなく、レコード盤や、カセットテープもありました。

一時ですがMDなどもありました。

ほんの一時ですがDATでリリースを試みるニュースか広告だかを見かけた事もありました。

放送や映画もありますし、ゲームなどで使われる事もあります。

それぞれに合わせたレコーディングをするのではなく、レコーディングはレコード作品としてその時に可能な最も良いフォーマットで録音しマスター音源を完成させます。

そのマスター音源を、必要なプラットフォームに合わせて適切に置換していきます。

これがマスタリングという工程になります。

CD、レコード、カセットテープ。

全て方式も違えば音も違います。

これらの最終メディアでは、ただ安直に元のマスター音源をコピーしただけでは良い作品にはなりません。

少しづつサウンドのキャラクターや特徴が違い音楽の意図が変化してしまうこともあります。

そのため、ミキシングされたマスター音源を適切に聴こえるようにメディアやフォーマットに合わせて調整をし、メディアやフォーマット毎のマスターを作成します。

例えばレコードであれば針飛びをしないようにとか、テープであればサチュレーションしすぎないようになど、ボリューム、EQ、トータルコンプレッションなどで処理を調整を加えていきます。

できるだけギリギリまで最大限の高音質で制作されるべき

つまりCDの44.1Kにするか、映像フォーマットの48Kにするか、はたまたアナログでリリースするか、などという事は「あくまでもリリース時の都合」であって、レコード作品自体は「その時に出来うる最も良い音質」で制作されるべきなのです。

シーケンスソフトのDAW化とCD-Rの登場

話を戻します。

1990年半ば頃になると、サウンドカードを取り付けてPCで、音楽を作るのが一般的になっていきました。そしてMIDIシンセサイザー音源が徐々にこれまでの外部ではなく、PC内部でプラグインソフトに置き換わっていきました。

これによって制作費の大幅なコストダウンができるようになり、大手レコード会社でなくても作品をリリースすることが可能になりました。

ノーマスタリングでのCD制作

DAWやCD-Rの普及にともなって、スタジオを使わずにPC内部で完結させる in the Boxという音楽制作手法が増えました。

そしてPC内部で完結させる手法であれば、44.1KhzフォーマットでバウンスしたファイルをそのままCD-Rにプリントすれば、プレス用のマスターCD(PMCD)として機能するようになったのです。

これによりマスタリング工程を省くことが可能になる大きな予算削減を実現できました。

が、本来のマスタリングプロセスとは大きく異なるために、皆、サウンド面に大きく苦労することになります。

その理由の1つが、前項で書いた48Kでレコーディングとミックスをしても44.1Kにバウンスをするとサウンドが大きく変わってしまう問題です。

どうせCDでしかリリースしない作品なのだから44.1Kで録音とミックスを行えば解決。

というクリエイターやエンジニアが増えたという件です。

データ容量の削減やPCの負荷を少しでも下げたい

サウンドライブラリーを44.1Kにした理由について、もう一つの理由としてPCに負荷を掛けない、ストレージ容量を抑えたいなどという理由もあったかもしれません。

ただ96Kならともかく48Kだと10%しか変わらないわけで、僕はゼロではないが大きな理由ではなかったと考えています。

が、ゼロでは無いでしょう。

これらの理由により44.1Khzが中心に

実際の数量では個人ユースに近い音楽クリエイターの方が多く、ライブラリーメーカーもその様なユーザーが使いやすい形を選択したという経緯があったと僕は感じていました。

44.1Kのライブラリーをで最適化するベストな方法は?

実際にこういったライブラリーをどうやって高品位なハイレゾレコーディング作品にマッチさせていくか、僕なりに20年近く試してきて選択している方法を紹介します。

完璧ではないにしろ、生演奏トラックにそれなりに負けない存在感や質感を出す方法です。

次善の策:DAWを「超高音質モード」でインポート

まずは時間が取れない場合や低予算案件の場合の手法です。

妥協の産物ですので、ベストではありません。

前項でも書きましたが編曲とシーケンスデータの制作が終わったら、ミックス用にオーディオファイルをバウンスします。

その際は主に使用しているサウンドライブラリー44.1Kであれば、DAWの設定は44.1Kにします。

そしてエクスポートするファイルも一切の演算処理を加えないように44.1Kでエクスポートします。

ProToolsなどへマルチトラックのWAVファイルをインポートしますが、その際にSRコンバートを掛ける方法です。

じっくりと時間を掛けて最適化してもらいます。

前項でも上げたようにこれは実演時間よりも時間が掛かります。

特にストリングス音源などの音像が複数あったり奥行きや広がりが重要な音源ほど差がでやすいです。

艶や伸びなどサウンドの美しさに違いが感じられます。

「ミックスの前にマルチトラックWAV?」という人はこちら

こうすることで、楽曲制作時のDAWの負荷を抑えられるだけでなく、最終的に作品をより高音質にできます。

最善の策:高音質DA <> AD でマルチトラックWAVへ

最も良い効果を産んでいるのは、DA→ADでマルチトラックにする方法です。

今の所、最も良い効果を産んでいます。

演算処理が入らないので余分なディザーノイズなどの影響も可能な限り抑えられます。

やり方は、2台のDAWを用意します。

1台は楽曲制作用。こちらを44.1Kで再生させます。

そしてもう1台、僕の場合はスタジオのProToolsです。

こちらのWCを48Kや96Kなどでレコーディングする方法です。

それなりの設備とシステムとノウハウが必要

このやり方は誰でもどんな環境でも良い結果が出せるわけではありません。

これらが必要です。

一般の家庭の雑電と安価なIOなどで同様の作業を行っても、音が痩せて鈍くなるだけかもしれません。

きちんとしたシステムが必要な事から、実際にこのやり方を選択している音楽クリエイターはそれほど多くはないと思います。

が特別に特殊な方法という訳ではありません。

ISOCHRONE TRINITY などはこういった用途でも使えるように1台で複数のWCを発信して同期が取りやすいようになっています。

フルハウスはまだTRINITYがリリースされる前にスタジオを建てたので、同メーカーのOCXというWCジェネレータを2台導入しています。

DA/ADコンバートでのポイント

ただし、この手法で良い結果を得るにはいくつかのポイントがあります。

PCでの演算処理をサウンド的な理由から少なくするために、プラグイン内部のボリュームやEQなどは全てバイパスします。

素のサウンドライブラリの波形を可能な限りそのまま出力させることに注力して、余分な処理を最低限に抑えます。

メリットとデメリット

これらによって驚くほどクリアなトラッキングが可能です。

ボリュームやEQなどの処理はトラッキング時のアナログ時や、最終ミキシングのProToolsの一発だけで決めます。

処理を可能な限り最低限の手数にすることで音抜けは抜群に良くなります。

一見大変そうですが、20年前にテープ式MTRにシーケンスパートをひとつひとつ毎回流し込んでいた僕からすると、極々普通の当たり前の作業なのです。

この手法メリットを上げると、

などなどです。

ただしデメリットともあります。

トラック数が多いと、相当な時間が掛かります。

昔はトラッキングだけで1日掛けることも珍しくなかったです。

近年はそれだけ予算に余裕のある状況はほぼ無くなってきましたので、事実上できなくなっています。

10数年前は高頻度で行っていた手法ですが、近年ではそういった作業が許される案件も少なくなり理想論になってきています。

生録音との差を少しでも埋めるために

打ち込みシーケンストラックなどの音源と、生演奏をレコーディングされたトラックでは大きな違いがあります。

近年のライブラリーはアーティキュレーションやピッチ、ベロシティー毎にかなり精細に生録音されたサンプルを使用してリアリティは大きく増していますが、それでもスタジオで生録音されたトラックと一緒に並んでくると、絶大ながっかり感が産まれます。

音楽的な表現のニュアンスの差は諦めが付くのですが、何とも残念なのは圧倒的な高域の汚さやレンジの狭さ。

この手法を行うことで、そういった部分がかなり改善します。

とは言え…。打ち込みMIDIシーケンスと生演奏録音の考え方は過去記事でも書いています。

これからのサウンドライブラリーに求めること

各メーカーは過去の膨大な44Kライブラリーをどうして行くのか気になります。

多くの人は現状の44KをSRコンバートして何も問題も不満もないと感じているかも知れません。

EDMなどのエレクトロ系の音楽であれば、そもそもオシレーターの発信がサンプルライブラリーではないので、サンプリングレートの影響を受けません。

その他の要因もあって、現状の放送や動画メディアに載せた時には、他の打ち込み制作楽曲よりも音抜けよく迫力があるように聴かせることができます。

音楽のムーブメントと環境は常に密接に関係しているので、コンテンツ内で「エレクトロ系のBGMにしよう」という要因のひとつになっているかもです。

過去のラブラリーの更新を

僕としては現在のアコースティック楽器系のインストゥルメント・プラグインに関しては、機能的にはそれほど不満はありません。

近年はより便利に、より簡単にという流れが主流になっているように感じています。

先日、大きくプロモーションしているオーケストラ音源があったので、ダウンロードしてみましたが、ストリングスやブラスなどの各セクションごとに、オープン、クローズでのメジャー、マイナーのハーモニーしかなく「誰でもオーケストラの曲が作れる」というスタンスのようでした。

「欧州の有名スタジオで有名オーケストラで録音したプロ向けの…」と謳っていましたが、いや、違うだろ…と。

個人的には現在、定番と言われている各種ソフトシンセに機能的に不満は無いです。

不満は、兎に角スタジオでトラックを並べた時に感じる、トップエンドの汚さや音の奥まり感や抜けのなさ。

これらを改善してくれるだけで良いので、プレイエンジンの改善と共にライブラリーの再収録、これをお願いしたい。

1番コストと時間がかかる部分なので、無理だろうけども〜

48Kでの再収録版をリリースしてくれるなら喜んで、新たなお布施を払います。

最近は公表しないメーカーが増えてきた

そして達の悪いことに最近はサンプルの収録レートを公表しない音源が増えてきました。

公表しているのかもですが、僕がHPを見る限りではどこにも記載がない、というのが増えています。昔は「44.1Khz/24Bitにて〇〇ホールにてレコーディング」なんて書いてあったとあるプラグインシンセも今は記載がなくなりました。

そうすると新規導入する度に、複数のサンプリングレートで書き出して最も音がクリアなものを探す必要があります。

最後にもう1回だけ書いておきます。

なぜ44.1Kでレコーディングした??

CDが無くなる時代が直ぐに来るなんて分かってたでしょ〜。

でした。

僕もNotator LOGIC(現LOGIC pro x)が、Ver 2.0になりLOGIC Audioへと名前を変えると、直ぐにサウンドカードを買い込み、PC内部でのオールデジタルでの楽曲作りを始めました。

当時は4chしか再生録音が出来ないので、トラック数の数だけピンポンバウンスを繰り返しながら数十トラックの作品を作りあげた記憶があります。

物凄く時間のかかる作業でしたが、オールデジタルのノイズレスというのは非常に魅力的でした。